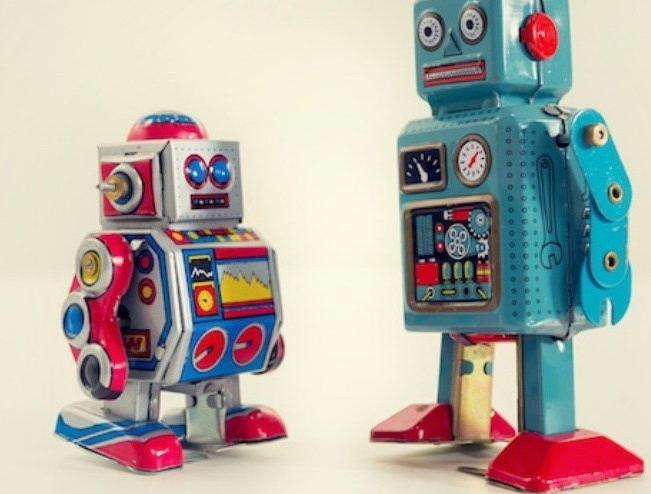

Google要将自身打造的网路爬虫机器人Googlebot所使用「REP」解析器开源,借此作为标准设计参考依据,并且期望能以此带动让「REP」协定设计能有更严谨、统一的标准。

Google稍早宣布,将针对1994年由荷兰软体工程师Martijn Koster提出的「Robot Exclusion Protocol (REP,网路爬虫机器人协定)」提出真正标准。

虽然过去25年以来,诸多网站与网路搜寻服务都是依照「REP」协定设计,透过存放在网站根目录的robot.txt宣告哪些内容可以被网路爬虫机器人撷取,以及撷取频率,但实际上「REP」协定设计并不严谨,例如网站停摆时候如何让网路爬虫机器人运作,同时网路爬虫机器人应该依照何种频率抓取网站内容,避免造成网站伺服器负担过重,或是无法即时抓取更新内容等,实际上并没有一定规范。

因此,就Google稍早提出想法,除了将自身打造的网路爬虫机器人Googlebot所使用「REP」解析器开源,借此作为标准设计参考依据,并且期望能以此带动让「REP」协定设计能有更严谨、统一的标准。

虽然目前还没有明确标准确定时程,同时也不代表未来将以Google提供版本为准,主要还是会考量不同类型网站使用需求微设计,借此减少网路爬虫机器人所产生问题,并且让网路内容能更容易被网路搜寻服务适时、适当地撷取内容,进而让更多人可透过搜寻引擎服务找到合适内容。

相关文章

- Google手机设计大变化!爆料图首见Pixel 6 有「三色背盖」05-14

- Google与Unity合作推动更多Unity游戏加入Stadia游戏服务03-25

- Google AI技术是如何识别信息真假的03-09

- Google相册App将迎新改版设计!2张对比图秒懂更新内容03-09

- Google助理已支持42种语言朗读网页文字包括中文03-06

- Google助理阅读网页内容功能怎么使用03-06

- Google Cloud卡达数据中心启用已遍布全球26个地区03-06

- Google聘请PS4《战神》游戏制作人并成立全新游戏工作室03-06

- Google Stadia新工作室公开!由前《战神》执行制作人领头03-05

- 游戏开发商抱怨Google为Stadia提供的资源太少03-05

最新文章

- 即时通讯软件解除网链屏蔽意味着什么09-14

热门文章

Google Chrome浏览器打字消失暂时解决输入法Bug的方法

Google Chrome浏览器打字消失暂时解决输入法Bug的方法 Google创办人辞去CEO、董事会主席职务具体原因介绍

Google创办人辞去CEO、董事会主席职务具体原因介绍 行踪纪录不怕被曝光!Google Map也要推「无痕模式」

行踪纪录不怕被曝光!Google Map也要推「无痕模式」- Google Play推出预算功能,可设定金额花费上限定期通知

- Google新社交软件Shoelace上线!主打「真实相处」、不要只上网聊天

- 「Google相机」有新调整!舍弃Smart Burst改推Top Shot拍摄模式

- Pixel 4 两大关键规格曝光!遭网友酸:Google 还是不够大方

- 用关键字也能搜到影片内容片段!Google搜寻新功能超佛心

- Google Pixel 4 又爆雷一次!屏幕、记忆体将大升级

- 手机狂跳出「中奖广告」 疑是Google广告出包